Серебро курс динамика: Курс серебра ЦБ, график и динамика. Цена серебра за грамм сегодня

Содержание

Вековая история цен на серебро | Ликбез инвестора

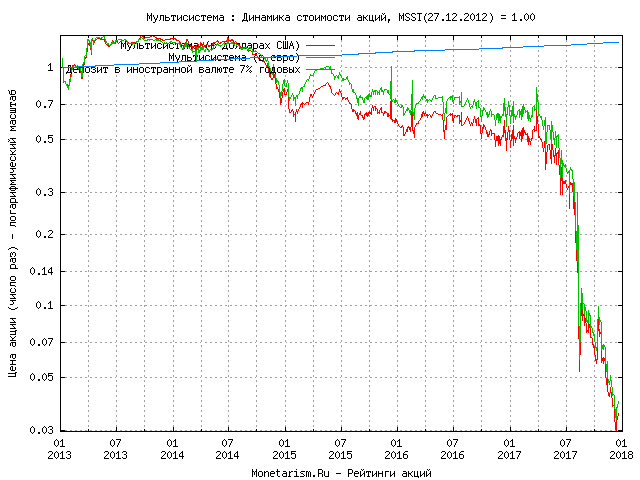

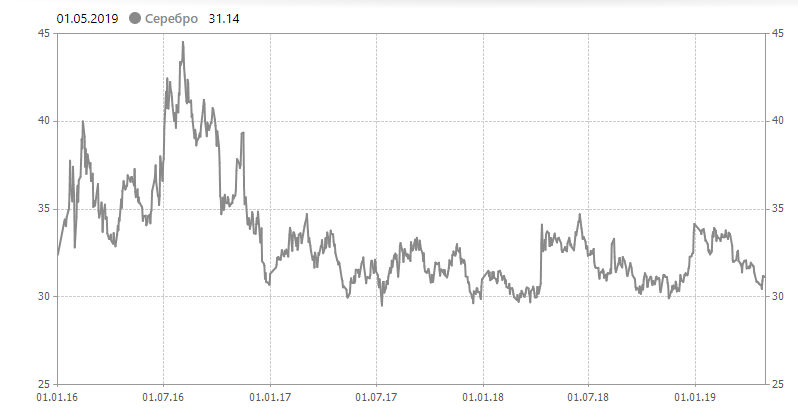

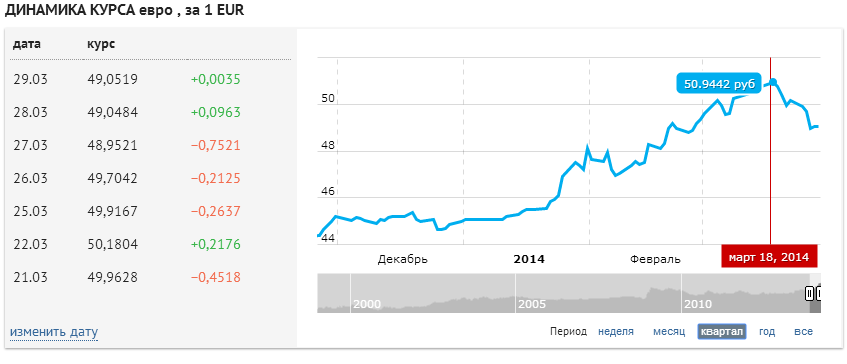

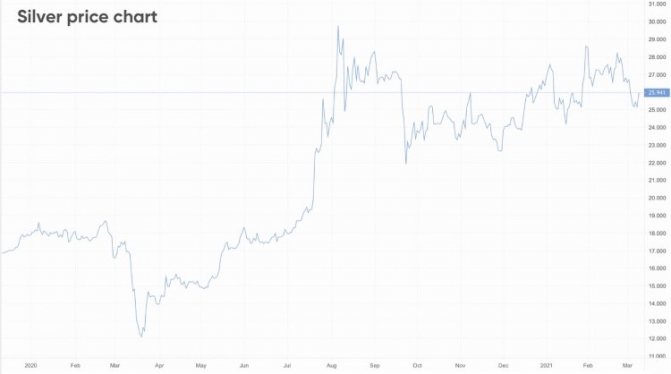

Ниже приведены графики годовых данных о ценах на серебро и ценовых тенденциях за последние 20 лет в различных валютах, включая доллар США, евро, британский фунт стерлингов, японскую иену, китайский юань и индийскую рупию.

Прошлые показатели рынка не являются гарантией будущих результатов, но исторические цены на серебро могут быть полезны для определения прошлых тенденций.

Драгметалл сейчас торгуется 24 часа в сутки, и на региональные цены могут влиять обменные курсы валют, экономическая политика, а также местный спрос и предложение.

Именно поэтому стоит обратить внимание на 20-летние графики цены на серебро в большинстве основных валют, а также 3-летние, 5-летние и 10-летние графики в долларах.

Исторические цены на серебро в основных валютах

Доллары США

Трехлетний график показывает, что драгметалл торгуется вблизи своих максимумов ($18 долларов за унцию).

Цена серебра в долларах США еще не превысила уровень $30 долларов за тройскую унцию за последние пять лет. Цены также не опустились ниже $14 долларов за унцию.

Цены также не опустились ниже $14 долларов за унцию.

На 10-летнем графике цен видно масштабы роста драгметалла до рекордных максимумов, превышающих $40 долларов за тройскую унцию в 2011 году.

Если увеличить временной интервал до 20 лет, то можно заметить, насколько дешевым был металл до финансового кризиса.

Движение выше и ниже линии 0% на графике трендов представляет собой периоды более высокой волатильности серебра в долларах США.

Цена на серебро неуклонно росла на протяжении всего XX века и в начале XXI века с кратковременными резкими скачками и падениями в 1979-1980 и 2011 годах.

Евро

Более 20 лет стоимость драгметалла в евро была немного стабильнее, чем в долларах США.

График ценовых тенденций показывает изменение цен на серебро в евро по сравнению с предыдущим годом.

Британские фунты

На графике цен на серебро в фунтах стерлингов немного меньше колебаний, учитывая высокий обменный курс британской валюты.

Годовая динамика демонстрирует такой же огромный скачок цен в 2011 году, как и в других валютах.

Иены

Стоимость серебра в иенах более плавно снижалась с рекордных максимумов по сравнению с ценами в фунтах и евро.

Иена была единственной основной валютой, цены на серебро в которой в годовом исчислении не опускались ниже базового уровня в 2009 году. В 2011 году также видно резкий скачок.

Китайские юани

Более резкое падение стоимости драгметалла в юанях отчасти связано с укреплением валюты в последнее десятилетие.

Динамика цен на серебро в юанях отражает динамику курса доллара, так как китайское правительство пытается удерживать «мягкую» привязку к доллару.

Индийские рупии

Рупия является важной валютой для ценообразования драгметалла, учитывая огромный спрос на драгоценные металлы в Индии.

На графиках серебра в рупиях наблюдается такой же рост в ограниченном диапазоне, что и в британских фунтах.

FAQ по серебру и серебряным монетам

Какая самая высокая цена в истории?

Самая высокая стоимость серебра в долларах США составляла около $48 долларов за тройскую унцию в конце апреля-начале мая 2011 года. Однако, с поправкой на инфляцию, пиковая цена была зафиксирована в 1980 году — примерно $30 долларов за унцию, в сегодняшних долларах — более $100 за унцию. Это поистине рекорд.

Однако, с поправкой на инфляцию, пиковая цена была зафиксирована в 1980 году — примерно $30 долларов за унцию, в сегодняшних долларах — более $100 за унцию. Это поистине рекорд.

Почему в 1980 году произошел резкий рост цен?

Хотя стоимость драгметалла росла на протяжении 1970-х годов, резкий скачок в 1980 году произошел благодаря паре богатых спекулянтов, братьям Хант. На короткое время они почти захватили мировой рынок серебра.

Когда была зафиксирована самая низкая цена?

Оглядываясь назад, можно сказать, что самая низкая цена на серебро (с поправкой на инфляцию) за последние 100 лет наблюдалась в январе 1931 года во время Великой депрессии. Драгметалл опустился до $29 центов за унцию. Однако на этот вопрос сложно ответить, учитывая, что серебро сохраняло свою ценность на протяжении тысячелетий — задолго до того, как оно было оценено в долларах США, британских фунтах или любой другой существующей валюте.

Поднимется ли серебро, если рухнет американская валюта?

Не обязательно. Если люди снова не начнут использовать этот драгметалл в качестве денег (при условии изменения законов), всегда будет необходимость устанавливать цену в определенной валюте. Положительным моментом является то, что исторически этот драгметалл демонстрировал тенденцию сохранять свою стоимость по сравнению с другими активами, независимо от инфляции или девальвации валюты.

Если люди снова не начнут использовать этот драгметалл в качестве денег (при условии изменения законов), всегда будет необходимость устанавливать цену в определенной валюте. Положительным моментом является то, что исторически этот драгметалл демонстрировал тенденцию сохранять свою стоимость по сравнению с другими активами, независимо от инфляции или девальвации валюты.

Какой была стоимость серебра год назад?

В прошлом году средняя цена на серебро была чуть выше $16 долларов за унцию. В начале года драгметалл торговался на уровне $15,65 за унцию. На протяжении 2019 года, он опустился до $14,30 за унцию, затем поднялся до $19,55 и закрыл год чуть ниже $18 за унцию.

Что лучше покупать, серебряные монеты или слитки?

Оба варианта имеют свои плюсы и минусы. Прочтите больше о серебряных монетах и слитках, чтобы узнать о различных преимуществах этих двух форм инвестиционного серебра.

Кому принадлежит больше всего серебра в мире?

Довольно сложно определить, кто владеет большими запасами, исходя из данных, находящихся в открытом доступе, по крупным инвесторам. Подразделение по торговле металлами JP Morgan часто открывает массивные позиции, но это не означает, что драгметалл принадлежит одному человеку. Уоррен Баффет в 1997 году приобрел более 100 миллионов унций, но с тех пор распродал свои запасы.

Подразделение по торговле металлами JP Morgan часто открывает массивные позиции, но это не означает, что драгметалл принадлежит одному человеку. Уоррен Баффет в 1997 году приобрел более 100 миллионов унций, но с тех пор распродал свои запасы.

Какое серебро лучше покупать?

Еще один сложный вопрос, потому что на него нет однозначного ответа. Все зависит от ваших личных целей инвестирования в драгметалл.

Автор: Стивен Кокран 1 октября 2020 | Перевод: Золотой Запас

Ошибка 404

Условия использования сайта

Подробнее Я согласен(а)

Внимание! Перед просмотром этого сайта внимательно прочитайте данные условия. Если вы не согласны с этими условиями, не используйте этот сайт.

Бесплатная оценка онлайн

Отправляя фото предмета (предметов) на бесплатную оценку (слабирование/продажа) через сайт SkupkaMonet.com.ua или с помощью (через) приложений (мессенджеры): Viber, WhatsApp, Telegram, Messenger или на почту [email protected] или иным другим способом (оговоренным заранее) Вы соглашаетесь предоставить достоверную и точную информацию о себе и своих контактных данных, а так же Вы гарантируете, что высланный на оценку предмет (предметы):

- находится у Вас на законных основаниях;

- Вы имеете все права им распоряжаться;

- предмет (предметы) не находится под арестом либо под запретом отчуждения;

- предмет (предметы) не является объектом судебного спора и отсутствуют какие либо основания для возникновения таких споров относительно данного предмета (предметов) с Вашим участием в будущем;

- предмет (предметы) не является объектом каких либо договоров, в том числе предварительных договоров относительно отчуждения или пользования с какими либо третьими лицами;

- предмет (предметы) не отягощен какими либо имущественными правами третьих лиц.

Высылая фотографию предмета (предметов) на бесплатную оценку (слабирование/продажа) через сайт SkupkaMonet.com.ua или с помощью (через) приложений (мессенджеры): Viber, WhatsApp, Telegram, Messenger или на почту [email protected] или иным другим способом (оговоренным заранее) Вы соглашаетесь с тем, что безвозмездно и бессрочно передаете нам все исключительные авторские и имущественные права на фотографию и ее использование на территории всего мира, для воспроизведения ее любым способом, включая переработку, распространение, передачу прав на фотографии третьим лицам и другие исключительные права, предусмотренные действующим законодательством Украины.

Использование сайта

Сайт SkupkaMonet.com.ua (далее «SkupkaMonet») разрешает вам просматривать и загружать материалы этого сайта (далее «Сайт») только для личного некоммерческого использования, при условии сохранения вами всей информации об авторском праве и других сведений о праве собственности, содержащихся в исходных материалах и любых их копиях. Запрещается изменять материалы этого Сайта, а также распространять или демонстрировать их в любом виде или использовать их любым другим образом для общественных или коммерческих целей. Любое использование этих материалов на других сайтах или в компьютерных сетях запрещается.

Запрещается изменять материалы этого Сайта, а также распространять или демонстрировать их в любом виде или использовать их любым другим образом для общественных или коммерческих целей. Любое использование этих материалов на других сайтах или в компьютерных сетях запрещается.

Oтказ от ответственности

SkupkaMonet в любое время без уведомления может вносить изменения в материалы и услуги, предоставляемые на этом Сайте, а также в упомянутые в них продукты и цены. SkupkaMonet ни при каких обстоятельствах не несет ответственности за любой ущерб (включая, но не ограничиваясь ущербом от потери прибыли, данных или от прерывания деловой активности), возникший вследствие использования, невозможности использования или результатов использования этого сайта.

Регистрация на сайте

Регистрируясь на Сайте, вы соглашаетесь предоставить достоверную и точную информацию о себе и своих контактных данных.

В результате регистрации вы получаете логин и пароль, за безопасность которых вы несете ответственность. Вы также несете ответственность за все действия под вашим логином и паролем на Сайте. В случае утери регистрационных данных вы обязуетесь сообщить нам об этом.

Вы также несете ответственность за все действия под вашим логином и паролем на Сайте. В случае утери регистрационных данных вы обязуетесь сообщить нам об этом.

Обратная связь и комментарии

Обращаясь к нам или оставляя комментарии на сайте, вы несете ответственность, что данное сообщение не является незаконным, вредоносным, угрожающим, клеветническим, оскорбляет нравственность, нарушает авторские права, пропагандирует ненависть и/или дискриминацию людей по расовому, этническому, половому, религиозному, социальному признакам, содержит оскорбления в адрес конкретных лиц или организаций, а также каким либо иным образом нарушает действующее законодательство Украины. Вы соглашаетесь, что любое ваше сообщение SkupkaMonet может удалять без вашего на то согласия, а также безвозмездно использовать по своему усмотрению. SkupkaMonet не несет ответственности за любую информацию размещенную пользователями Сайта.

Использование персональных данных и конфиденциальность

Мы используем различные технологии для сбора и хранения информации, когда вы посещаете сайт SkupkaMonet. Это может включать в себя запись одного или нескольких куки или анонимных идентификаторов. Мы также используем куки и анонимные идентификаторы, когда вы взаимодействуете с услугами, предложенными нашими партнерами, такими как рекламные услуги, например, которые могут появиться на других сайтах.

Это может включать в себя запись одного или нескольких куки или анонимных идентификаторов. Мы также используем куки и анонимные идентификаторы, когда вы взаимодействуете с услугами, предложенными нашими партнерами, такими как рекламные услуги, например, которые могут появиться на других сайтах.

Мы соблюдаем законодательство Украины в сфере защиты персональных данных (Закон України «Про захист персональних даних»).

Доставка Новой Почтой, без предоплаты, наложенным платежом по всей Украине.

Оплата только после проверки товара Вами лично — в отделении службы доставки (Новая Почта) в вашем городе (населенном пункте). Оплата — Наличными в отделении службы доставки.

Внимание!

При получении товара в отделении службы доставки (Новая Почта), обязательно проверяйте наличие всего товара в заказе, а так же его внешний вид. Если Вы передумали, при получении товара в отделении службы доставки, просто откажитесь от покупки — это бесплатно.

В случае повреждения товара, или неполной комплектации заказа — необходимо отказаться от получения товара и его оплаты, а так же составить акт (претензию). В случае если данная ситуация будет иметь место — обязательно сообщите нам о случившемся по тел: 0 800 33 1912

В целях безопастности, в нашем офисе нет склада и точки выдачи монет. Доставка и оплата происходит в отделениях служб доставки (Новая Почта) в вашем населенном пункте, если не оговорено иное.

Условия доставки и оплаты для оптовых клиентов или для товаров стоимость которых превышает 15 000 грн, обговариваются заранее в телефонном режиме.

Мы гарантируем, что все монеты оригинальные, никаких подделок!

Мы гарантируем что упаковка заказанного товара обеспечит целостность и сохранность его товарного вида.

Оплата только после проверки Вами лично товара — в отделении службы доставки в вашем городе.

100% предоплата — уменьшает стоимость заказа! Возврат 100% предоплаты — вы можете отказаться от покупки в момент осмотра товара в отделении службы доставки Новая почта, деньги мы вернем в ближайшее время!

Мы гарантируем, что все монеты оригинальные, никаких подделок!

Мы гарантируем что упаковка заказанного товара обеспечит целостность и сохранность его товарного вида.

Внимание!

При получении товара в отделении службы доставки (Новая Почта), обязательно проверяйте наличие всего товара в заказе, а так же его внешний вид. Если Вы передумали, при получении товара в отделении службы доставки (Новая Почта), просто откажитесь от покупки — это бесплатно.

В случае повреждения товара, или неполной комплектации заказа — необходимо отказаться от получения товара и его оплаты, а так же составить акт(претензию). В случае если данная ситуация будет иметь место — обязательно сообщите нам о случившемся по тел: 0 800 33 1912

[Третий раунд / Заархивированное сообщение] Курс RL Дэвида Сильвера — Лекция 3: Планирование с помощью динамического программирования | от Jae Duk Seo

Пожалуйста, обратите внимание, что этот пост предназначен для моих собственных образовательных целей.

На прошлой неделе → задачи Маркова → сформулированы → теперь мы будем работать над решениями.

Оценка политики → насколько хороша эта политика, а что нет → что мы собираемся охватить. (значение итерации и многое другое). (общий РЛ будет сформулирован в будущем).

(значение итерации и многое другое). (общий РЛ будет сформулирован в будущем).

Динамическое программирование → мы собираемся решить какую-то нестабильную задачу → отсюда динамика → метод оптимизации для последовательных методов. (решить сложную задачу). → основная идея состоит в том, чтобы разбить сложную проблему на более мелкие проблемы. (один пример — кратчайший путь). → разделяй и властвуй → перекрывающиеся подзадачи → подзадачи возникают снова и снова → мы можем решать их более эффективно. (интересно). → Таким образом, мы можем решить RL, используя это. (мы можем кэшировать наше решение).

MDP → удовлетворяют обоим свойствам → уравнение Беллмана — это рекурсивная декомпозиция. (функция значения состояния → в рекурсивное отношение).

DP → мы собираемся использовать DP для планирования → кто-нибудь скажет нам вероятность перехода. (два особых случая → прогнозирование и контроль. Прогноз → дайте нам MDP с политикой → то, что мы просим → функция ценности! (любое состояние → сколько вознаграждение).

Контроль → полная оптимизация → MDP → теперь мы собираются получить наилучшую политику (более полное решение) (DP → можно использовать в различных областях → например, планирование и т. д.)

Мы можем начать с → получения функции значения → после нескольких итераций → сходимости к функции значения истинного состояния. (синхронизация → все состояния одновременно). (это сходится)

У нас есть дерево упреждения → дерево упреждения на один шаг → нам нужно получить значение корня → мы говорим, что уравнение верно → и мы хотим превратить это в итерацию решение. (и повторяем его до сходимости). (это сходится → есть доказательство).

Состояния перед конечным состоянием → будут иметь высокие значения → в то время как другие значения не имеют такого высокого значения. (это государственная стоимость).

Это истинное значение с течением времени. (начать с нуля → но со временем → сходиться к значениям истинного состояния). (и мы можем сделать лучшую политику → действовать жадно по отношению к функции значения состояния. ) (таким образом, мы можем начать с функции значения состояния → и увеличивать политику → по одной оптимизации за раз).

) (таким образом, мы можем начать с функции значения состояния → и увеличивать политику → по одной оптимизации за раз).

Теперь мы найдем → наилучший полис.

Начните со случайной политики → предпримите жадное действие → со временем это действительно сходится.

Жадная политика → детерминирована → поиск оптимальной политики → просто поиск лучшего метода.

Итак, это проблема альтернативной оптимизации. (так что для любой среды → мы собираемся сойтись в одном месте → оптимально).

Политика ничего не делать → и сверхурочная работа → сходятся в определенной политике, где → нам нужно переставить определенные машины на места. (нам нужна динамика → системы → вероятность перехода уже известна). (после нескольких итераций → значение состояния сходится). (скорость сходимости не зависит от начальных значений).

Таким образом, → общий подход заключается в следующем: → в настоящее время → действовать жадно → в следующем действии → мы будем как минимум не хуже текущего действия. (максимальное общее действие → будет суммироваться → поэтому мы видим, что политика улучшается).

(максимальное общее действие → будет суммироваться → поэтому мы видим, что политика улучшается).

Таким образом, функция значения состояния → действительно улучшается → это все, о чем говорит приведенное выше уравнение.

Если улучшение прекратилось → значит, мы удовлетворили оптимальному уравнению посыльного → теперь мы действуем наиболее оптимально. (Pi — оптимальная политика). (итерация политики → решение для MDP → теперь итерация значения). (а как насчет долгой задержки? → жадность не означает, что мы смотрим только на следующий шаг → скорее → видим весь шаг! → так что стреляйте в материнские корабли).

Итерация значения → Не нужно повторять значение состояния → мы можем просто выполнить один запуск для функции значения состояния. (Остановитесь раньше → посмотрите на ошибку посыльного → просто остановитесь). (или мы можем даже найти более наивные вещи → три шага и готово).

DP → рассмотреть только одно состояние → подзадачу → и решить ее → накопление этого подхода позволит решить проблему оптимально. (одно из требований оптимальности).

(одно из требований оптимальности).

После одной итерации → мы собираемся оптимизировать политику. (опять и опять). (это тоже сходится).

Для любого состояния → у нас есть оптимальное действие. (финальное состояние теперь дается, как показано выше → обновить каждое состояние → и, наконец, оно сходится со временем). (нет конечного состояния → это действительно работает → DP все еще работает и находит оптимальное решение → это просто общий обзор). (динамика еще дана → не полная проблема РЛ).

Итерация значения против итерации политики → строгой политики нет → мы работаем в состоянии значения → что это значит? → может не быть значением для какой-либо реальной политики → но это сходится.

Посмотрите на это максимальное значение → оно нелинейно меняет все. (опять же → это оптимальное уравнение Беллмана → обновляется на каждой итерации).

Хорошее резюме → кажется, есть → метод асинхронного метода обновлений. (контроль и предсказание — это разные вещи).

Сложность этих двух методов различается.

DP → можно обновлять только определенное состояние → не обновлять каждое состояние → сократить вычисления. (пока мы выбираем один раз → это сработает).

Асинхронный метод динамического программирования.

Это скорее трюк программирования → просто обновите напрямую. (без хранения двух переменных). (это оптимизирует значение).

Теперь у нас могут быть некоторые приоритеты. Очередь → чтобы выбрать состояние, которое обновляется больше всего. (можно выбрать только топ-100 или топ-20).

Соберите реальные образцы → и обновите только то, что испытал агент. (DP стоит дорого → не самое масштабируемое решение). (решение по образцу).

[Архивное сообщение] Курс RL Дэвида Сильвера — Лекция 3: Планирование с помощью динамического программирования | от Jae Duk Seo

Пожалуйста, обратите внимание, что этот пост предназначен для моих собственных образовательных целей.

Видео с этого сайта

Динамическое программирование

Одно из фундаментальных понятий, связанных с управлением, оптимальное управление. (самая старая идея).

(самая старая идея).

Оценка политики → Насколько хороша эта политика? (Итерация → Найти оптимальную политику → Берет идею, лежащую в основе оценки политики, и зацикливает ее, делая ее все лучше и лучше с каждой итерацией.) (Наилучшая возможная политика).

Итерация значений → Работает непосредственно с функцией значений и пространством значений, а не с пространством политик. (Оптимальное решение).

Расширения для динамического программирования и многое другое. (общие методы RL.). Почему такие методы работают.

Динамическое программирование → Последовательный или временной аспект в задаче. (Математическое программирование → Оптимизация политики, отображение состояния на действие.). Метод оптимизации для последовательных задач.

Разбить на подзадачи → Решить их → решить исходную задачу. (два свойства → оптимальная подструктура → Решите подзадачу, чтобы решить исходную задачу. ) Кратчайший путь → из точки A в B → Разбивка от A к C к C к B.

) Кратчайший путь → из точки A в B → Разбивка от A к C к C к B.

Возьмите наше оптимальное решение и решите меньшие задачи первый. (затем соедините их вместе). Подпроблемы возникают снова и снова → Много раз много раз.

Общая структура динамического программирования. (И MDP прекрасно заполняет оба свойства.). (Уравнение Беллмана — это рекурсивная декомпозиция → Как разбить функцию оптимального значения на две части → оптимальное значение для одного шага и оптимальное значение для следующего шага.). (Идея сохранения какого-то временного лучшего решения, которое можно использовать снова и снова → в целом кажется очень эффективным, если предположить, что кэшированное решение является лучшим решением.).

DP → Предположим, что вы полностью знаете MDP → кто-то уже рассказал нам о динамике MDP, теперь мы просто хотим решить эту MDP. (Как мы решаем MDP?).

Может решить для прогнозирования → Сообщите нам MDP и политику или MRP → выход – это функция значения.

Вышеприведенное является своего рода оценкой политики. Следующее — контроль. (Кто-то уже сказал нам, что MDP → Дает подробную информацию о мире, но нет политики → какая политика лучше?).

Следующее — контроль. (Кто-то уже сказал нам, что MDP → Дает подробную информацию о мире, но нет политики → какая политика лучше?).

Планирование, Строка, График, Графические модели Алгоритм → Решения для динамического программирования (многое другое).

Оценка политики (сообщите нам MDP → но хотите оценить это.)

Хотите оценить число пи (политика) → Используйте уравнение Белла (и у нас есть разные варианты этих уравнений). мы собираемся превратить уравнение Белла в итеративное обновление.

Синхронное резервное копирование → Обновите все вместе и эта процедура сойдется.

Мы собираемся преобразовать приведенное выше уравнение в итеративное обновление. (и вычислять его снова и снова до сходимости.) (это итеративная оценка политики).

У нас есть сетка 4*4 → и заштрихованная сетка – это конец эпизода → Теперь, где есть четыре действия, которые мы можем выбрать → Вверх Вниз Влево Вправо → Награда мы получаем -1 награду за шаг → только в заштрихованной области мы прекратить получать отрицательное вознаграждение.

Мы можем начать с фокусировки в левом столбце → у нас есть функция значения (значение для каждого отдельного состояния). Теперь мы применяем один шаг оценки политики и получаем новое значение (k=1) → Теперь снова делаем процедуру (k=2), и мы начинаем сходиться. (Вообще лучший метод поиска политики — это итерационный метод, а не аналитическое решение.)

Когда у нас есть политика случайного обхода, значения будут сходиться, как показано выше, и для определенной позиции у нас будет в среднем 20 шагов до попадания в заштрихованную область. (Функция ценности помогает нам определить лучшую политику.)

Итерация политики (в предыдущем случае у нас была только одна политика случайного обхода, теперь мы хотим узнать лучшую политику). (процесс обратной связи).

Как сделать нашу политику лучше? → Применение этого процесса снова и снова даст нам оптимальную политику.

- Оценить политику → вычислить функцию значения

- Улучшить политику, действуя жадно.

В общем, нам нужно больше итераций, чтобы найти наилучшую политику. (всегда сходятся к оптимальной политике).

Хороший метод решения MDP. (Независимо от того, с чего вы начнете, мы всегда найдем оптимальную политику). (пример с игрушкой → прокат автомобилей → 2 разных места, максимум 20 автомобилей в каждом месте → случайный возврат запроса. Мы хотим иметь оптимальное количество автомобилей в каждом месте, чтобы мы всегда могли сдавать в аренду разным людям.)

Визуализация итеративного метода решения будет выглядеть примерно так, как показано выше. (в общем, в разных отраслях некоторые люди создают модель → и, используя итерацию политики, находят оптимальную политику). Теперь более формальное определение политики улучшения. Рассмотрим детерминированную политику a = pi(s). (жадная политика улучшает значение за один шаг времени.)

Короче говоря → Жадное действие приведет к большей или равной сумме вознаграждения от предыдущей политики. (Все, что мы показали до сих пор → жадная политика дает какую-то ценность вознаграждения. ).

).

Этот процесс когда-нибудь перестанет улучшаться? → да, улучшение в какой-то момент остановится.

И когда приведенное выше уравнение удовлетворяется, мы нашли нашу оптимальную политику. (Для слова с малой сеткой нам потребовалось всего три итерации, чтобы найти грубое приближение оптимальной функции политики.)

Итерация измененной политики → Основная идея состоит в том, чтобы остановиться раньше, либо иметь условие остановки (с некоторой частотой ошибок), либо выполнить k итераций и только до k итерации улучшения. (очень разумно), однако, когда k = 1, это то же самое, что итерация значения.

Итерация значения (Теперь сосредоточьтесь на значении, а не на политике)

Итерация значения → политика может быть разделена на две части: оптимальное первое действие → оптимальное второе, и эту процедуру можно продолжить.

Мы собираемся использовать приведенное выше, чтобы сделать итерацию значения → дерево просмотра на один шаг вперед.

Снова похожая идея итерации → интуиция, лежащая в основе здесь, состоит в том, что мы начинаем с конца проблемы, и мы возвращаемся назад, чтобы найти наиболее оптимальный путь. (мы не собираемся этого делать, а скорее перебираем все пространство состояний, но общая идея здесь).

Другой маленький мир сетки → Здесь мы пытаемся найти кратчайший путь → к серому состоянию → общая идея состоит в том, чтобы начать с серого состояния и вернуться обратно. И в конце v == 7 мы получаем правильное значение для другого состояния. (На практике алгоритм не смотрит из конечного состояния → алгоритм все еще работает, даже если он не знает конечного состояния.).

Итерация значения → найти оптимальную политику из MDP

Опять же, идея состоит в том, чтобы получить более оптимальную функцию значения за итерацию.

Разница в итерации значения и политике → для итерации значения мы не строим прямую политику. Мы работаем со значениями напрямую. (итерация значения и итерация политики делают разные вещи.